Blick in die Blackbox

Die künstliche Intelligenz hat enorme Fortschritte gemacht. Doch sie hat auch gravierende Schwachstellen. Welche? Und warum? Kommen Sie mit auf Teil II unserer Reise durch Digitalien.

Von Thomas Preusse, Hanna Wick, 26.06.2018

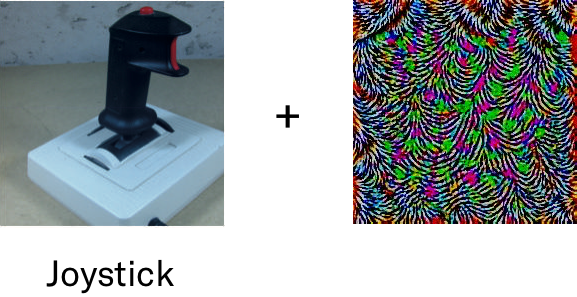

Seyed Moosavi hat ein Problem: «Ich vertraue der Software nicht.» Das ist, für einen Computerwissenschaftler wie ihn, äusserst unangenehm. Klar, es kann immer mal vorkommen, dass im Code ein Fehler hockt, dass ein Programm nicht macht, was es sollte. Doch Moosavis Problem geht tiefer: Er hat es mit einer Software zu tun, die sich prinzipiell nicht reparieren lässt. Zumindest bis jetzt nicht. «Die Software funktioniert in den allermeisten Fällen super. Nur manchmal, da versagt sie spektakulär.» Und das bloss, weil der Forscher von der ETH Lausanne den Input ein bisschen geändert hat, mit einem störenden Muster. Wir Menschen sehen einfach über das Muster hinweg. Doch der Computer verwechselt plötzlich einen Heissluftballon mit einem Labrador. Oder einen Joystick mit einem Chihuahua.

Die Beispiele klingen so absurd, dass sie schon fast lustig sind. Aber nur fast. Denn die Computersysteme, mit denen sich der Forscher herumschlägt, könnten bald über Leben und Tod entscheiden. Es handelt sich dabei um sogenannte künstliche neuronale Netze (auch bekannt als Deep Learning). Sie sind der Kern dessen, was man heute landläufig unter künstlicher Intelligenz versteht, und sie erobern die Industrie im Sturm: Selbstfahrende Autos finden damit ihren Weg durch den Verkehr. Ärztinnen erkennen damit Krebs im Gewebe. Und Innovationsförderer bekommen glänzende Augen.

Seit einigen Jahren boomt der Einsatz von neuronalen Netzen in der IT-Industrie. Die Idee dahinter stammt aus den 1950ern. Doch erst seit wenigen Jahren funktioniert sie richtig gut – dank schnelleren Computern und riesigen Datensammlungen, mit denen sich die Netze trainieren lassen. Mittlerweile kommt keine grosse Software-Firma mehr um die Technik herum.

Der Hype um neuronale Netze hat einen guten Grund: Kein anderes Computerprogramm kann so schnell so viel aus Daten lernen wie dieses. Will man Maschinen beispielsweise beibringen, Katzen zu erkennen, braucht man sie bloss mit tonnenweise Bildern zu füttern. Dann lässt man sie daran üben, gibt ihnen Feedback, und schwups erkennen die Programme Katzen auf Bildern, die sie nie zuvor gesehen haben. Sie können auch Krebszellen erkennen. Oder Muster in Aktienkursen. Oder deine Stimme und was du sagst. Oder das Gesicht deiner Liebsten in Fotos auf Facebook.

Und – oh ja! – sie können mittlerweile auch Neues erschaffen. Sie machen Bilder, schreiben Musik und Drehbücher, generieren Gesichtsbewegungen und Stimmen. Und sie beherrschen bestimmte Spiele besser als jeder Mensch, zum Beispiel das asiatische Brettspiel Go.

Serie «Talk to the Machine»

Hanna Wick und Thomas Preusse bringen Ihnen in drei Folgen bei, wie man mit Maschinen spricht: Sie beleuchten unsere nicht ganz unbelastete Beziehung mit Computern mit einem Blick in die Vergangenheit, die Gegenwart und die Zukunft.

Sie lesen: Teil II

Einblick in die Blackbox

Teil III

Programmier dich doch selbst!

Neuronale Netze sind nicht einfach eine Fortentwicklung des traditionellen Programmierens; sie sind nicht bloss Befehle des Menschen an die Maschine in Nullen und Einsen (lesen Sie dazu Teil I unserer Reise). Ihre Funktion ist fundamental anders. Vorbild von neuronalen Netzen ist das menschliche Gehirn. Und das arbeitet assoziativ, dezentral, zufällig.

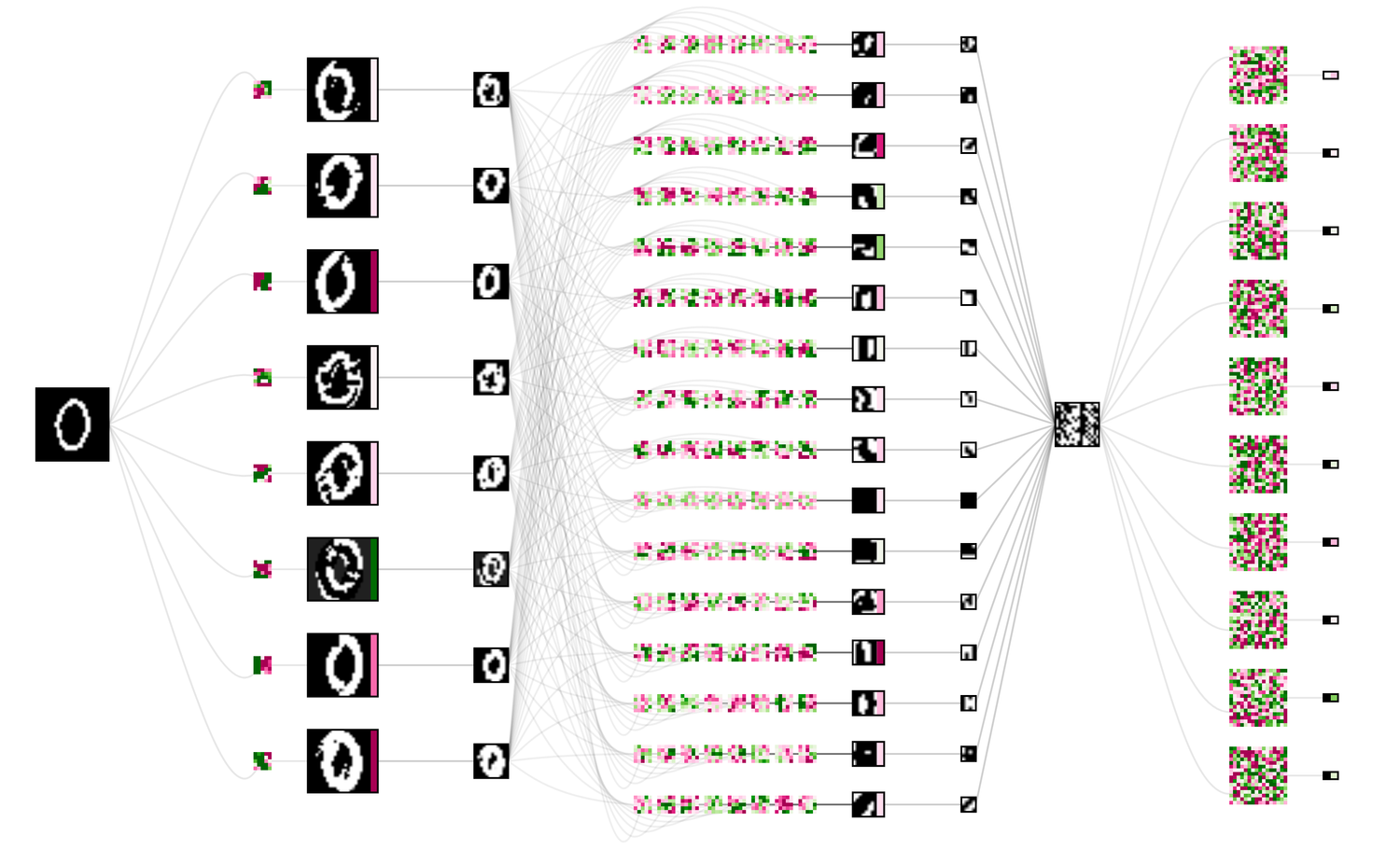

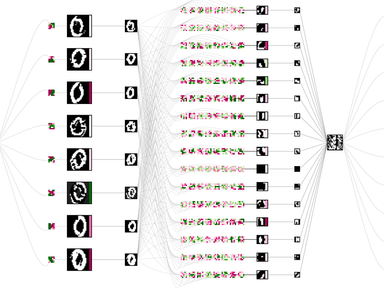

Ein künstliches Gehirn haben die Entwickler zwar (noch) nicht geschaffen. Aber sie haben sich einiges vom Gehirn abgeschaut: So wie dort einzelne Nervenzellen Impulse weitergeben, so leiten im Computer Knotenpunkte Signale weiter. Diese Knotenpunkte befolgen eine simple Regel: Sie nehmen den Dateninput an, machen etwas damit und geben das Signal dann weiter. Nach einer Bewertung wird das Resultat vorne wieder eingespeist, mit einer Prise Zufall. Das geschieht so lange, bis der Output die gewünschte Form hat.

Das Grundprinzip ist nicht besonders kompliziert. Wohl aber die Architektur der Software: Ein neuronales Netz enthält Hunderte von Knotenpunkten, organisiert in verschiedenen Schichten. Je mehr Schichten, desto tiefer das Netz – daher der Name «Deep Learning» – und desto schwieriger zu verstehen, was genau passiert.

Die Programmiererin gibt also ein Stück Kontrolle ab, wenn sie ein neuronales Netz einsetzt. Sie kann es nach ihren Vorstellungen trainieren, aber sie kann es nicht durchschauen wie herkömmliche Programme.

Bei einem herkömmlichen Computerprogramm kann man mit genügend Zeit prinzipiell jeden einzelnen Schritt nachvollziehen – bis hinunter zu den Nullen und Einsen. Da ist alles logisch und durchsichtig. Bei einem neuronalen Netz hingegen lernt eine Software, einen bestimmten Trick zu vollführen – ohne dass am Ende klar wäre, wie genau sie zum richtigen Resultat kommt. Ein Nachteil, den immer mehr Entwickler auf sich nehmen, weil neuronale Netze verflixt praktisch sind. Sie lernen schnell und können meisterhaft Muster erkennen – zum Teil besser als wir Menschen.

Doch was heisst «erkennen», was heisst «lernen»? Was wissen neuronale Netze tatsächlich über die Welt? «Ziemlich wenig», sagt Moosavi. «Sonst könnte man sie nicht so leicht austricksen.»

Schon 2013 entdeckte ein Forscherteam mit Beteiligung von Google und Facebook, dass neuronale Netze zwar sehr genau, aber nicht wahnsinnig robust sind. Die Entwickler veränderten in einem Bild einige wenige Pixel, und schon brach die Klassifizierung bestimmter neuronaler Netze komplett zusammen. Das Resultat schlug ein wie eine Bombe. Es zeigte, dass man neuronale Netze leicht in die Irre führen kann.

Heute gehören diese sogenannten adversarial examples zu den heissesten Themen des Fachs. «Jede Woche kommen neue Arbeiten dazu heraus», sagt Irina Nicolae vom IBM-Forschungszentrum Irland. «Doch noch hat niemand eine gute Gegenstrategie gefunden.» Sie selbst sucht nun nach Lösungen, die Robustheit von neuronalen Netzen wenigstens irgendwie zu beziffern – mit einer Art TÜV für Software. Denn nicht alle neuronalen Netze sind gleich anfällig.

Hundertprozentig sicher ist aber keines. Das hat Seyed Moosavi vor kurzem gezeigt. Er hat nämlich einen Weg gefunden, neuronale Netze generell lahmzulegen. Universelle Attacken, sozusagen. «Und kein System ist gegen solche Attacken immun», sagt er.

Irren ist maschinell

Die künstliche Intelligenz lässt sich also ein X für ein U vormachen. #NichtGut. Man kann sich leicht vorstellen, dass jemand so selbstfahrende Autos vom Weg abbringen oder Kampfdrohnen auf falsche Ziele richten könnte. Eine ungemütliche Vorstellung.

Auch für den Computerwissenschaftler David Gunning. Er leitet bei der Forschungsabteilung des US-Verteidigungsministeriums (Darpa) ein grosses Programm, das die künstliche Intelligenz verbessern soll. «Die Systeme sind eine Blackbox», so erklärt es Gunning jeweils in seinen Vorträgen. «Wir wissen heute nicht, warum neuronale Netze eine bestimmte Entscheidung treffen, und auch nicht, wie man ihre Fehler verbessern kann.»

Selbst das Militär sieht: Die künstliche Intelligenz ist kein Allheilmittel. Wer das nicht zugibt und die Software mystifiziert, verfolgt eigene Ziele.

Mark Zuckerberg verspricht dem US-Kongress, bald werde künstliche Intelligenz (Artificial Intelligence, kurz AI) die Probleme von Facebook lösen. Das Versprechen soll die Politiker milde stimmen und Facebook Zeit verschaffen, bevor schärfere Regulierungen kommen. Quelle: CSPAN, Schnitt: Isabelle Schwab

Gunning wünscht sich mehr Durchblick, mehr Klarheit. In der Forschergemeinde ist er damit nicht allein. Neuronale Netze sind zwar – unumstritten – ein gewaltiger Fortschritt. Doch die rosa Brille hat niemand mehr auf. Der Google-Entwickler Ali Rahimi hat die künstliche Intelligenz kürzlich in einem Vortrag sogar mit Alchemie verglichen. Also mit einem seltsamen Rezept, das manchmal funktioniert, das aber niemand richtig versteht.

«Wir sagen Dinge wie: ‹Maschinelles Lernen ist die neue Elektrizität.› Ich möchte eine andere Analogie vorschlagen: Maschinelles Lernen ist die neue Alchemie.»Ali Rahimi / NIPS 2017

Viele Durchbrüche bei der künstlichen Intelligenz basieren allein auf Versuch und Irrtum, nicht auf rigoroser Wissenschaftspraxis. Das heisst: Die Entwickler schrauben so lange an den neuronale Netzen herum, bis diese tun wie geheissen. Die funktionierenden Tricks tauschen sie dann untereinander aus wie Fans die Musik ihrer Lieblingsband. Hast du das schon gesehen? Das musst du ausprobieren!

Doch warum eine Lösung besser funktioniert als eine andere, das weiss niemand. Man kann zum Beispiel ganze Teile eines wichtigen Übersetzungsalgorithmus weglassen, und er läuft danach sogar besser als vorher. Das zeigt, wie wenig die Programmierer ihre neuronalen Netze bis jetzt verstehen. Und trotzdem: Weil die Technik so phänomenal gut funktioniert, wollen sie alle möglichst rasch anwenden.

Man kann das auch begrüssen, so wie Yann LeCun, einer der wichtigsten Pioniere des Gebiets. «Es ist keine Alchemie, es ist Ingenieurarbeit. Und die ist nun mal chaotisch.»

Damit haben wir einen Konflikt, den Wissenschaftler und Ingenieurinnen immer wieder mal austragen: Sollte man die Welt erst verstehen, bevor man etwas zu verändern sucht? Oder gleich tüfteln und probieren, im Vertrauen, dass die Erkenntnis dann schon irgendwann kommt?

Zurzeit stehen die Zeichen bei den neuronalen Netzen eher auf: Vollgas voraus. Jetzt bloss nicht bremsen bei dieser tollen Technik. Doch bei einer Brücke, dem Inbegriff von Ingenieurskunst, möchte man irgendwann auch verstehen, warum sie hält und nicht fällt. Spätestens nach der Katastrophe, wenn sie eben doch gefallen ist.

Genau dieses Verständnis fordern viele nun bei den neuronalen Netzen, bevor es zur ersten Katastrophe kommt. Auch die IBM-Forscherin Nicolae: «Wir müssen diese Probleme dringend lösen. Sonst riskieren wir einen Backlash gegen die künstliche Intelligenz.»

Das Seilziehen um die Zukunft des Forschungsgebiets wird noch verschlimmert, weil sich viele Resultate der künstlichen Intelligenz nicht reproduzieren lassen. Ein Team bringt seinem neuronalen Netz etwas bei. Doch wenn ein anderes Team dasselbe versucht, scheitert es kläglich. Der Grund: Die Teams machen ihren Code nicht öffentlich zugänglich und geben nicht bekannt, mit welchem Datensatz und wie genau sie das neuronale Netz trainiert haben. Das aber wäre entscheidend, denn jedes neuronale Netz ist ein bisschen anders.

Manchmal reicht ausserdem die Rechenpower nicht zur Überprüfung – vor allem bei Hochschulen, die Resultate von Google, Facebook und Co. nachbauen wollen. Denn neuronale Netze brauchen viel Kapazität. «Das ist eine bedauerliche Asymmetrie», sagt ETH-Forscher Moosavi. «Die Industrie dominiert das Forschungsgebiet, auch wegen der Ressourcen. Aber immerhin ist sie heute aufgeschlossener als früher und macht einen Grossteil ihrer Resultate öffentlich.»

Austricksbare Algorithmen, alchemistisches Herumprobieren – die Probleme sind klar. Bei den Lösungen aber tappen sowohl Akademie als auch Industrie noch ziemlich im Dunkeln. Die Software zu verwenden: Kinderspiel. Sie zu verstehen: Knacknuss. «Dafür braucht es brillantere Köpfe», sagt Moosavi. Wahrscheinlich tragen viele Dinge zu den Schwachstellen bei – zum Beispiel die Geometrie des Netzes, die mathematische Struktur und auch die Daten, mit denen es gefüttert wird.

Diese Daten sind es auch, die neuronale Netze ziemlich in Schieflage bringen können. Sind sie unausgewogen, können rassistische oder sexistische Resultate herauskommen. Wie beim Chatbot von Microsoft, der Juden und Frauen verunglimpfte. Weil er es so (von uns Menschen) gelernt hatte. Schlechte Daten führen zu schlechten Entscheidungen. Oder anders gesagt: Wer gute Daten hat, gewinnt.

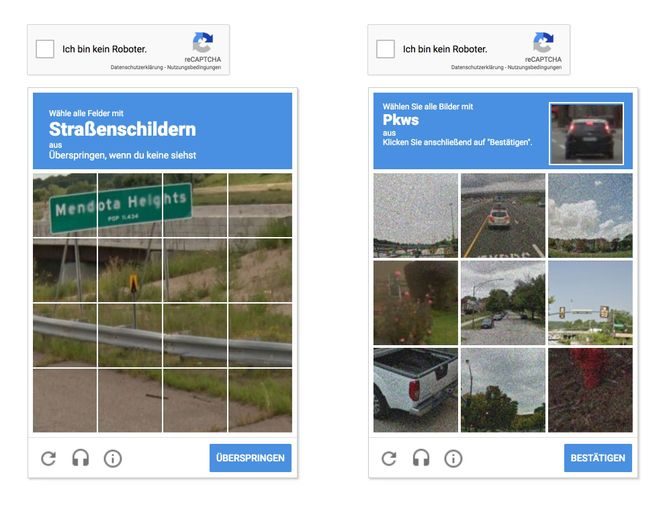

Darum wacht die Industrie über ihre Daten wie ein Drache über sein Gold. Darum versuchen kleinere Firmen heute bereits, naturnahe Daten künstlich zu erzeugen. Und darum spannt die Firma Google uns regelmässig ein, um ihre selbstfahrenden Autos zu verbessern. Auch Sie, liebe Leserin, sind dabei mit im Boot – jedes Mal, wenn Sie sich durch ein solches CAPTCHA klicken.

CAPTCHAs waren ursprünglich gedacht, um Mensch und Maschine zu unterscheiden. Nun helfen sie den Maschinen, uns Menschen ähnlicher zu werden.

Intelligent genug sind die neuronalen Netze trotzdem noch nicht. Menschen haben zwar auch Schlagseite, auch sie irren manchmal. Doch Computer sollen besser sein als wir. Sicherer, zuverlässiger, fairer. Das ist der Anspruch. Und das sind neuronale Netze heute noch nicht.

Was heisst das für die Gesellschaft? Wie sollen die Gesetzgeber damit umgehen?

Eine Antwort darauf gibt die neue europäische Datenschutz-Grundverordnung (DSGVO), die Ende Mai in Kraft getreten ist. Sie fordert, dass die Entscheidungen von Software erklärbar sein müssen. Ein Beispiel: Eine Person bekommt von der Bank keine Hypothek, weil ein neuronales Netz sie als nicht kreditwürdig einstuft. Die Person darf die Bank nun fragen, warum so entschieden worden ist und was sie tun müsste, um trotzdem einen Kredit zu bekommen. Noch können Banken, die auf künstliche Intelligenz setzen, diese Frage nicht beantworten. Bald müssen sie es.

Wie sinnvoll die DSGVO im Bereich künstliche Intelligenz ist, darüber gehen die Meinungen auseinander. Viele begrüssen die neue Regelung. Der US-Computerexperte Pedro Domingos hingegen ist nicht begeistert. Im Interview mit dem «Spiegel» nimmt er das Beispiel der Krebsdiagnose zur Hand: «Ist es mir lieber, meine Diagnose basiert auf einem Algorithmus, der zu neunzig Prozent akkurat, aber im Detail nicht erklärbar ist – oder auf einem, der zu achtzig Prozent genau ist, den ich aber verstehe? Ich würde mich für das genauere System entscheiden.»

Der dritte Weg wäre freilich, neuronale Netze so zu verbessern, dass man in Zukunft beides haben kann: Performance und Verständlichkeit. Dafür braucht es neue Ideen. Mehr Struktur, mehr symbolisches Verständnis, mehr rigorose Mathematik, so Seyed Moosavi. Seine Kollegin Irina Nicolae von IBM ist gleicher Meinung: «Wir brauchen mehr Theorie, damit wir nicht mehr so im Dunkeln rumtappen.»

Noch glauben die beiden Forscher daran, dass sich neuronale Netze retten lassen. Es könnte aber auch sein, dass sich irgendwann mathematisch zeigen lässt: Neuronale Netze sind niemals durchschaubar. Und sie sind niemals robust, sondern immer anfällig für Attacken. Erste Resultate aus der Küche von Google Deepmind deuten in diese Richtung. «Dann müssten wir uns entscheiden: Nehmen wir das Risiko in Kauf, oder verzichten wir bei sicherheitsrelevanten Anwendungen auf den Einsatz von neuronalen Netzen?», sagt Moosavi. «Ich jedenfalls würde dann kein selbstfahrendes Auto kaufen.»

Und jetzt: Was lesen Sie in Teil III unserer Reise?

Was ist mit der Angst vor Supermaschinen, die uns Menschen intellektuell haushoch überlegen sein könnten? Dafür würde es zuerst einmal Computer brauchen, die sich selbst programmieren. In Teil III lernen Sie morgen einen Forscher kennen, der genau daran arbeitet – ebenfalls mit künstlicher Intelligenz.

Debatte: Wie behalten wir die Maschinen im Griff?

Sind wir zu sehr von Maschinen abhängig? Oder nehmen sie uns genau die Arbeiten ab, die uns nur lästig sind und die sie sowieso besser können? Haben Sie Angst davor, dass Maschinen einmal besser funktionieren als das menschliche Gehirn? Und warum muss ich eigentlich selbst programmieren können? Hier geht es zur Debatte mit Autorin Hanna Wick und IT-Spezialist Andreas Moor (heute Mittwoch von 8 bis 11 Uhr).